Un jour, la communication publique fera vraiment du data mining

Les métiers de la communication publique sont passionnants. Notamment parce qu’ils font appel à de très nombreuses compétences qu’il s’agit d’accumuler au fil du temps. Et c’est plutôt excitant de se dire que chaque jour qui passe apporte son lot de découvertes. Ce billet propose de revenir sur l’évolution de nos fonctions et d’insister sur une nouvelle compétence que nous tardons un peu trop à acquérir à mon sens : la maîtrise de la science des données. En somme, intégrer quelque chose de l’ordre du « data mining », ou engager un « data scientist » dans nos équipes, à défaut de le devenir nous-mêmes.

Par Marc Thébault.

Dircoms : 6 ingénieries à maîtriser, plus 1 !

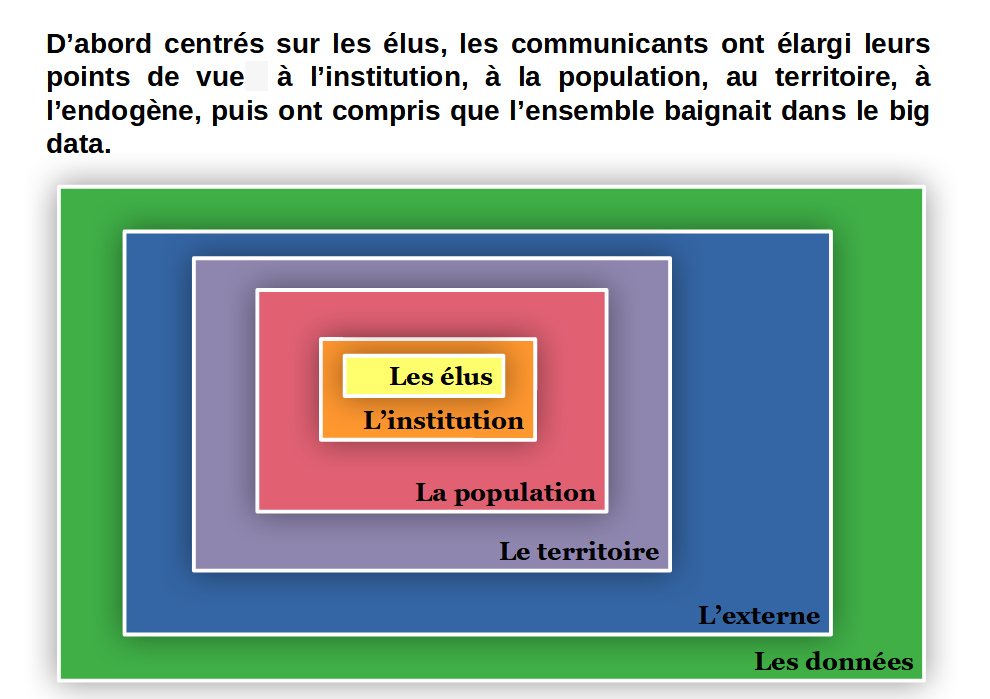

Avec l’évolution de nos fonctions et de la société, nous avons intégré de plus en plus de nouvelles compétences, de nouvelles bases théoriques, de nouveaux outils. J’ai l’habitude d’évoquer l’évolution de nos métiers en sept étapes, sept niveaux d’ingénierie qui sont venus non pas s’exclure, mais au contraire se superposer. Présentation rapide :

Il y a d’abord eu l’ingénierie du consentement, phase de propagande largement théorisée par Edward Bernays, en 1928, avec Propaganda. Puis celle de l’information, lorsque de premiers dircoms, la plupart anciens journalistes, ont intégré les collectivités et que la boîte à outils se limitait au « bulletin » ; règne aussi de la vision simpliste de la communication où il suffirait de dire (d’écrire en l’occurrence) pour que l’autre reçoive et acquiesce. Vint ensuite l’ingénierie de la persuasion, notamment lorsque la publicité a tenté d’envahir le secteur public, principalement après la victoire de Mitterrand en 1981 avec sa désormais célèbre campagne « La force tranquille » concoctée par Séguéla. Et sans oublier les lois de décentralisation, dites « lois Defferre », qui, de 1982 à 1986, ont donné aux maires de plus en plus de pouvoirs, donc de plus en plus de nécessités de communication. Est ensuite arrivée l’ingénierie de la relation où participation et écoute ont été les maîtres mots, d’abord en raison, entre autres, de la loi LOADDT de 1999 (« loi Voynet »), mais aussi parce que l’on commençait déjà à tenter de pallier une défiance envers la démocratie représentative (avec une abstention en hausse) en insufflant de la démocratie participative. Du coup, les communicants ont élargi leurs champs de référence aux sciences sociales et humaines. L’arrivée du Minitel en 1982 a ouvert l’ingénierie de la technologie, largement revivifiée depuis, avec internet et les réseaux sociaux, et pas sans conséquence sur la précédente ingénierie de la relation. Le début des années 2000 a certainement vu l'arrivée de l’ingénierie territoriale avec l’apparition du marketing territorial, notamment dans le développement économique, lorsqu’il a été question, en particulier, de créer les pôles de compétitivité en application de la « stratégie de Lisbonne » de l’Europe (2000-2010) qui ne voyait le salut que dans l’innovation et la R&D, pour fonder une « économie de la connaissance ». Et désormais, c’est l’ingénierie analytique qui devrait nous préoccuper, avec la gestion et l’exploitation des fameuses et innombrables « données », donc du big data. Vous l’avez pressenti, cela va bien au-delà de la seule maîtrise d’internet et des réseaux sociaux.

Résumé, certes un peu simpliste, en une image :

Ainsi, les communicants ont sacrément élargi leurs champs de compétences, intégrant à chaque nouvelle évolution à la fois de nouvelles bases théoriques et à la fois l’utilisation de nouvelles techniques, de nouvelles technologies, de nouveaux outils.

Je vais m’arrêter uniquement sur la dernière phase, forcément la plus palpitante car totalement d’actualité, histoire de me demander si, par hasard, le métier de communicant public ne devrait pas s’enrichir de capacités à manier la science des données. En somme, s’il ne devrait pas devenir un rien « data scientist » et se lancer dans le « data mining » ?

Vous avez dit « data scientist » ?

Un « data scientist » est un spécialiste (sur le mode « détective ») des problèmes analytiques complexes, de la science des données, « un vaste champ multi-disciplinaire visant à donner du sens aux données brutes », précise le site datascientest.com.

Il a pour mission le traitement, l’analyse et la valorisation des données massives (big data). Vous le verrez donc traîner avec une excitation certaine vers les « data warehouse » ou les « data lake » (voir sous ce lien). « Après les avoir analysées rigoureusement de façon à établir une stratégie organisationnelle et opérationnelle pour son entreprise, il en tire des solutions marketing, commerciales, de fidélisation clientèle ou encore de valorisation de l'image de marque », écrit le site e-marketing.fr.

Pour lebigdata.fr, la compétence du data scientist permet « d’explorer et d’analyser les données brutes pour les transformer en informations précieuses permettant de résoudre les problèmes de l’entreprise ». En somme, « en plongeant dans ces informations à un niveau granulaire, [il] peut découvrir et comprendre des tendances et des comportements complexes. Il s’agit de faire remonter à la surface des informations pouvant aider les entreprises à prendre des décisions plus intelligentes ».

De tout cela, il va développer des « data products » (à ne pas confondre avec les « data insights », plutôt considérées comme aides à la décision de l’entreprise), souvent via des algorithmes. Exemples : les moteurs de recommandation d’Amazon ou de Netflix, la boîte aux lettres Gmail (et son traitement des spams) ou la « vision » des voitures autonomes. Il va aussi permettre la visualisation de ces résultats.

Intéressez-vous aux datas, car elles s’intéressent déjà à vous !

Vous n’avez rien compris ? Cela prouve bien que nous avons tout intérêt à nous intéresser à ce sujet. Parce que lui s’intéresse déjà à vous ! D’ailleurs, pour ne citer que cela, toutes celles et tous ceux qui ont un tantinet côtoyé la notion d’attractivité ont forcément été démarchés par des start-up vendant des solutions «miracles » de compilation de données, de toutes sortes, de leur territoire et pouvant même établir des comparaisons avec des territoires considérés comme concurrents. Ces prestataires étant en mesure de compiler des chiffres et des résultats de toute provenance. Évidemment, la difficulté ne réside pas tant dans le fait d’aller chercher des chiffres, elle réside plus, à mon sens, quant à leur analyse, leur mise en perspective et les éventuelles prises de décision qu’ils pourraient suggérer.

Il en est de même pour les classements. Qui, après avoir savouré les bons résultats de son territoire – ou au contraire avoir maudit les organisateurs en cas de déception dans le rang obtenu –, a vraiment pris le temps d’aller chercher la méthodologie utilisée et regardé les critères retenus ? Quand villesetvillagesouilfaitbonvivre.com publie ses résultats (avec à la clé l’incitation à acheter des plaques d’entrée de ville, sacré Thierry Saussez !) et annonce que 187 critères ont été pris en compte, qui a voulu ou pu les regarder de près ? Qui a demandé les détails pour son territoire et qui a pris le temps de les vérifier un par un ? Qui est allé examiner les chiffres publiés sur votre commune dans le site DataFrance et a tenté de prendre contact avec eux pour les mettre à jour ou les rectifier ? C’est pourtant sur eux que se fonde un site comme partirdeparis.fr pour « noter » les territoires et leur attractivité.

Pour le dire plus directement, c’est une évidence, nous avons en principe accès à un nombre impressionnant de données, notamment avec l’open data, qui pourraient être utiles pour orienter les politiques publiques, peaufiner nos actions de communication ou fonder un argumentaire d’attractivité. Mais prenons-nous le temps de le faire ? Et, surtout, saurions-nous exploiter cette immensité de données ?

La science des données, quelque chose de bien trop sérieux pour le laisser aux seules mains des informaticiens

Depuis plusieurs années, les start-up les plus solides mettent en avant un développement fondé sur des faits et des chiffres, pas sur des intuitions ou du doigt mouillé, je parle du growth hacking, en tous les cas de ses aspects les plus positifs. Qui s’en inspire dans le secteur public ? Et qui a lu le rapport de la mission Bothorel « Pour une politique publique de la donnée » présenté en décembre 2020 au Premier ministre ? Votre DSI peut-être, mais quid de vous ? Au début d’internet, comme lors de l’apparition des réseaux sociaux, les directions informatiques se sont souvent mobilisées les premières et il a fallu, pour certains communicants, batailler ferme pour reprendre la main ; cela peut-il servir de leçon ?

Déjà, et je ne dois pas être le seul, lorsqu’il s’agit de donner du sens aux performances de nos posts sur les réseaux sociaux (voir sous ce lien), notamment s’ils sont sponsorisés, histoire de voir si notre argent est bien employé, c’est déjà une sacrée paire de manches ! Qui connaît d’ailleurs la différence entre les Analytics et les fichiers logs (voir sous ce lien) pour analyser le trafic de votre site ? Et qui a pris le temps d’aller se promener sur le site opendatafrance.net et ses sources de données ou sur data.gouv.fr et toutes ses thématiques, sans parler même de l’Insee et ses nombreuses études chiffrées et commentées ?

Et qui s’est amusé à croiser des résultats ? Par exemple, dessiner une nouvelle carte du territoire avec, par quartier, les prix de l’immobilier, le profil des habitants, les stations de transports en commun, les faits relevant de la délinquance et les résultats aux dernières municipales ? Un certain nombre d’opérateurs proposent des études sur les flux de déplacement (par exemple Flux Vision chez Orange). Qui a déjà utilisé ce type d’études pour revoir un plan de déplacement, un jalonnement, un réseau de pistes cyclables ou de transport en commun, ou un circuit touristique ?

Qui est sorti de la croyance « Il faut parler de tout, à tout le monde, tout le temps » pour envisager des « persona » que l’on pourrait cibler suivant leurs centres d’intérêts, leurs comportements et leurs caractéristiques propres ? Pensons-nous vraiment qu’il est essentiel qu’un jeune adulte de 20 ans passionné par le sport soit aussi informé des programmes d’animation des Ehpad municipaux ? Certes, certains sites proposent des entrées « famille », « étudiant », « entrepreneur », « visiteur », etc. Mais nous devrions aller bien plus loin dans la segmentation, non ? Et pour finir de vous convaincre, cet article « Le big data et l’open data au service des collectivités » qui, déjà en 2016, posait clairement et avec brio les enjeux.

En conclusion, nous avons passé des décennies à nous plaindre de manquer d’éléments de connaissance de nos publics ou de nos prospects. Cette fois, ces outils sont à portée de main. Si ce n’est que, vous le savez déjà, c’est désormais un vrai métier que d’apprendre à s’y retrouver et à les mettre au service de votre prospective professionnelle. Ainsi, ce nouveau champ de compétence me semble indispensable à investir, soit directement, soit en recrutant les personnes idoines. Certes, quelques collectivités se sont lancées dans cette aventure, notamment pour les gestions de risques, par exemple d’inondations, ou pour leur SIG. Mais quid de la communication ? Et qui sait si tout cela ne serait pas pertinent également pour l’évaluation de nos actions ?